Soit ![]() la distance entre 2 sources ponctuelles. Il existe une valeur

minimale de

la distance entre 2 sources ponctuelles. Il existe une valeur

minimale de ![]() en dessous de laquelle les sources ponctuelles ne sont

plus discernables après reconstruction. Cette distance définit la résolution

spatiale. On la définit comme la largeur totale

à mi hauteur de la réponse impulsionnelle de la caméra. Cette résolution spatiale

globale est influencée par :

en dessous de laquelle les sources ponctuelles ne sont

plus discernables après reconstruction. Cette distance définit la résolution

spatiale. On la définit comme la largeur totale

à mi hauteur de la réponse impulsionnelle de la caméra. Cette résolution spatiale

globale est influencée par :

Par sensibilité, on entend le rapport entre le nombre d'événements vrais enregistrés par unité de temps et la concentration radioactive effectivement présente dans le champ de vue. C'est donc la quantité d'informations acquises à partir de laquelle l'image doit être reconstruite. On l'exprime usuellement en fréquence d'événements (évnt/s) par concentration d'activité (Bq/ml). Il faut noter que l'optimisation de la sensibilité se fait en général au détriment de la résolution spatiale. En effet la sensibilité dépend également de la taille et de la disposition des détecteurs [74].

A faible activité, le taux de comptage de coïncidences vraies varie linéairement avec l'activité alors que le taux de comptage des coïncidences fortuites varie selon le carré de l'activité [32,45]. Cependant, la montée du signal lumineux et sa décroissance, la formation du signal électronique par le PM, puis le traitement subi entraîne un temps mort pendant lequel le système ne peut pas compter de nouveaux événements. Si l'intervalle de temps moyen séparant l'arrivée de deux événements est grand devant ce temps mort, la variation du taux de comptage en coïncidence vraies en fonction de l'activité reste effectivement linéaire. En revanche, lorsque l'activité est telle que l'intervalle de temps moyen séparant l'arrivée de deux événements est du même ordre de grandeur que la durée du temps mort, il apparaît une non-linéarité qui traduit une perte de comptage.

Pour décrire les performances d'un imageur TEP, il est bon de mentionner :

Lors d'une acquisition, on cherche à compter le nombre de photons ![]() détectés simultanément suivant des lignes de coïncidence. L'ensemble de ces

mesures constitue le sinogramme. Or, nous avons

vu Par.3.1.3.1 que:

détectés simultanément suivant des lignes de coïncidence. L'ensemble de ces

mesures constitue le sinogramme. Or, nous avons

vu Par.3.1.3.1 que:

Les coïncidences supplémentaires ne font qu'introduire un bruit lors de la reconstruction.

Il est donc indispensable de les estimer au mieux pour pouvoir en corriger les

effets. On définit la fraction de diffusés Compton

![]() et la

fraction de fortuites

et la

fraction de fortuites

![]() avec

avec

|

|||

|

Elles affectent principalement les basses fréquences de l'image. Les méthodes

de corrections reposent sur la soustraction d'une valeur constante. Cette dernière

représente la contribution estimée des fortuits au nombre total d'événements

enregistrés sur chaque ligne de coïncidence. Elle peut être évaluée à partir

du taux de comptage de photons isolés reçus par chaque détecteur. Le taux de

fortuits ![]() (nombre de coïncidences fortuites par unité de temps)

est donc tel que :

(nombre de coïncidences fortuites par unité de temps)

est donc tel que :

Par diffusion Compton dans le

milieu imagé, certaines lignes de coïncidences sont faussées. La fraction de

ces photons surtout pour une acquisition 3D sans septa est importante. En effet

la probabilité pour des photons ![]() d'énergie 511 keV d'interagir

dans des tissus humains est élevée. Elle entraîne une dégradation du contraste

et de la résolution des images, qu'il est difficile de minimiser et de corriger.

En effet, la diffusion dépend à la fois de l'objet imagé et de la géométrie

d'acquisition. il suffit de voir le nombre de méthodes proposées et envisagées

pour se rendre compte que la correction du diffusé est complexe. On peut distinguer

les méthodes de corrections suivant qu'elles interviennent avant, pendant où

après la reconstruction. Nous n'évoquerons ici que la première catégorie. Pour

cette seule catégorie, il est encore nécessaire de distinguer :

d'énergie 511 keV d'interagir

dans des tissus humains est élevée. Elle entraîne une dégradation du contraste

et de la résolution des images, qu'il est difficile de minimiser et de corriger.

En effet, la diffusion dépend à la fois de l'objet imagé et de la géométrie

d'acquisition. il suffit de voir le nombre de méthodes proposées et envisagées

pour se rendre compte que la correction du diffusé est complexe. On peut distinguer

les méthodes de corrections suivant qu'elles interviennent avant, pendant où

après la reconstruction. Nous n'évoquerons ici que la première catégorie. Pour

cette seule catégorie, il est encore nécessaire de distinguer :

Dans le champ de vue, les photons peuvent disparaître par effet photoélectrique,

ils sont absorbés et cèdent toute leur énergie à un électron du milieu. Si on

se réduit à ce seul effet, et si on se fixe une ligne de coïncidence

![]() ,

une émission en un point

,

une émission en un point ![]() sur cette ligne produit 2 photons

sur cette ligne produit 2 photons

![]() et

et

![]() qui se déplacent en opposition sur cette droite. Chaque

photon peut interagir par effet photoélectrique avec le milieu du champ de vue

sur son parcours jusqu'aux détecteurs

qui se déplacent en opposition sur cette droite. Chaque

photon peut interagir par effet photoélectrique avec le milieu du champ de vue

sur son parcours jusqu'aux détecteurs ![]() et

et ![]() . Chaque photon

. Chaque photon

![]() à donc une certaine probabilité

à donc une certaine probabilité

![]() d'être

détecté qui dépend du facteur d'atténuation linéique du milieu traversé (On

suppose pour simplifier que le coefficient du milieu peut être considéré comme

constant). Comme les parcours des photons une fois émis sont indépendants, la

probabilité pour que les deux photons soient détectés simultanément par

d'être

détecté qui dépend du facteur d'atténuation linéique du milieu traversé (On

suppose pour simplifier que le coefficient du milieu peut être considéré comme

constant). Comme les parcours des photons une fois émis sont indépendants, la

probabilité pour que les deux photons soient détectés simultanément par ![]() et

et

![]() est :

est :

![\begin{displaymath}

\begin{array}{cl}

I\! \! P_{1,2} & =I\! \! P_{1}\times I\! \...

...u .M_{1}M_{2}\right] \; si\: \mu \: est\: constant.

\end{array}\end{displaymath}](img217.png)

Nous venons de voir que dans notre façon de compter les photons ![]() en coïncidence, il existait de nombreuses sources d'erreur, mais ce serait oublier

que durant la durée de l'examen, ces photons proviennent d'une désintégration,

et qu'une telle désintégration est un processus dont la nature est intrinsèquement

aléatoire. Autrement dit, pendant un intervalle de temps, le nombre de désintégrations

et par conséquent le nombre de paires de photons émises est soumis à des fluctuations.

Le processus d'émission des positons obéit à une statistique de Poisson. Il

est clair que le nombre de positons émis est fonction de l'activité radioactive

de l'objet imagé. En TEP, la nature radioactive du patient provient d'un traceur

injecté ou inhalé. Il est donc nécessaire de limiter au maximum l'exposition

à la radioactivité, ceci réduit évidemment le nombre de coups qui seront émis

durant la durée de l'examen. Ces fluctuations statistiques sont évidemment présentes

tout au long du processus d'acquisition et de reconstruction. Ce bruit présent

à la source, va se propager durant toute la chaîne et va altérer le signal.

Il semble donc alors essentiel de caractériser en fin de chaîne, i.e. après

reconstruction, le signal restant par rapport au bruit présent dans l'image.

en coïncidence, il existait de nombreuses sources d'erreur, mais ce serait oublier

que durant la durée de l'examen, ces photons proviennent d'une désintégration,

et qu'une telle désintégration est un processus dont la nature est intrinsèquement

aléatoire. Autrement dit, pendant un intervalle de temps, le nombre de désintégrations

et par conséquent le nombre de paires de photons émises est soumis à des fluctuations.

Le processus d'émission des positons obéit à une statistique de Poisson. Il

est clair que le nombre de positons émis est fonction de l'activité radioactive

de l'objet imagé. En TEP, la nature radioactive du patient provient d'un traceur

injecté ou inhalé. Il est donc nécessaire de limiter au maximum l'exposition

à la radioactivité, ceci réduit évidemment le nombre de coups qui seront émis

durant la durée de l'examen. Ces fluctuations statistiques sont évidemment présentes

tout au long du processus d'acquisition et de reconstruction. Ce bruit présent

à la source, va se propager durant toute la chaîne et va altérer le signal.

Il semble donc alors essentiel de caractériser en fin de chaîne, i.e. après

reconstruction, le signal restant par rapport au bruit présent dans l'image.

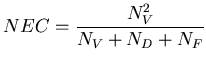

Une mesure globale du rapport signal/bruit a été introduite par Strother et

collaborateurs [93]: il s'agit du Noise Equivalent Contraste.

Ce ![]() représente le nombre

de coïncidences vraies devant être accumulées par un tomographe parfait (sans

diffusé ni fortuits) pour avoir le même rapport signal sur bruit que le tomographe

réel considéré. Strother et collaborateurs montre que le rapport signal sur

bruit au centre d'un fantôme homogène est proportionnel à la quantité

représente le nombre

de coïncidences vraies devant être accumulées par un tomographe parfait (sans

diffusé ni fortuits) pour avoir le même rapport signal sur bruit que le tomographe

réel considéré. Strother et collaborateurs montre que le rapport signal sur

bruit au centre d'un fantôme homogène est proportionnel à la quantité

![$\displaystyle NEC=\frac{N^{2}_{V}}{(1+\left[ \frac{N_{D}}{N_{D}+N_{V}}\right] ^{2}).[N_{V}+N_{D}+(1+k).N_{F}]}$](img224.png)

Le ![]() ne donne pas d'information sur le bruit en un point quelconque

de l'image mais peut être utilisé pour comparer les performances de deux caméras,

ou d'une même caméra pour des modes d'acquisition différents.

ne donne pas d'information sur le bruit en un point quelconque

de l'image mais peut être utilisé pour comparer les performances de deux caméras,

ou d'une même caméra pour des modes d'acquisition différents.